Spätestens mit ChatGPT ist Künstliche Intelligenz (KI) zum Thema unserer Zeit geworden – auch im Bereich von Software-Medizinprodukten.

Viele Hersteller sind sich unsicher, inwiefern KI überhaupt in Medizinprodukten eingesetzt werden darf. Aus diesem Grund wollen wir uns in diesem Artikel mit dem Einsatz künstlicher Intelligenz, insbesondere Machine Learning (ML), in regulierten Medizinprodukten befassen.

Wir fokussieren uns in diesem Leitfaden auf die Implikationen der Medical Device Regulation (MDR) für KI-basierte Medizinprodukte.

Dabei wollen wir unter anderem die folgenden Fragen klären:

- Darf ein Medizinprodukt überhaupt KI enthalten? Erhält man hierfür überhaupt eine Zulassung?

- Darf ein KI-Medizinprodukt während der Nutzung im Live-Betrieb kontinuierlich weiterlernen?

- Welche speziellen Gesetze und ISO/IEC Standards sind einzuhalten?

- Was möchte die benannte Stelle in Bezug auf KI-Medizinprodukte sehen?

- Was müssen Sie während der Entwicklung von Künstlicher Intelligenz als Medizinprodukt beachten?

- Können Sie LLMs wie ChatGPT in Ihrem Medizinprodukt nach MDR nutzen?

Zuallererst stellt sich dabei die Frage:

Was macht KI überhaupt so besonders im regulatorischen Sinn?

Wieso sollte man hierfür überhaupt eine Extra-Behandlung im Sinne der Gesetzgebung erwarten?

Inhalte dieses Artikels

- 1. Regulatorische Besonderheiten von künstlicher Intelligenz (KI)

- 2. Zulassung nach MDR: Medizinprodukte mit künstlicher Intelligenz

- 2.1 Anforderungen an die Entwicklung von KI-Medizinprodukten

- 2.2 Was erwartet die benannte Stelle in Bezug auf KI-basierte Medizinprodukte?

- 2.3 Relevante Normen und Leitfäden für künstliche Intelligenz in Medizinprodukten

- 2.4 Welche Machine Learning-Modelle sind als Medizinprodukt zertifizierbar?

- 2.5 Können Sie LLMs wie ChatGPT in Ihrem Medizinprodukt nach MDR nutzen?

- 2.6 Kosten und Aufwand für die Zulassung

- 3. Weitere regulatorische Anforderungen für KI

- 4. Fazit

1. Regulatorische Besonderheiten von künstlicher Intelligenz (KI)

Um die regulatorischen Besonderheiten von KI zu verstehen, sehen wir uns folgendes Beispiel an:

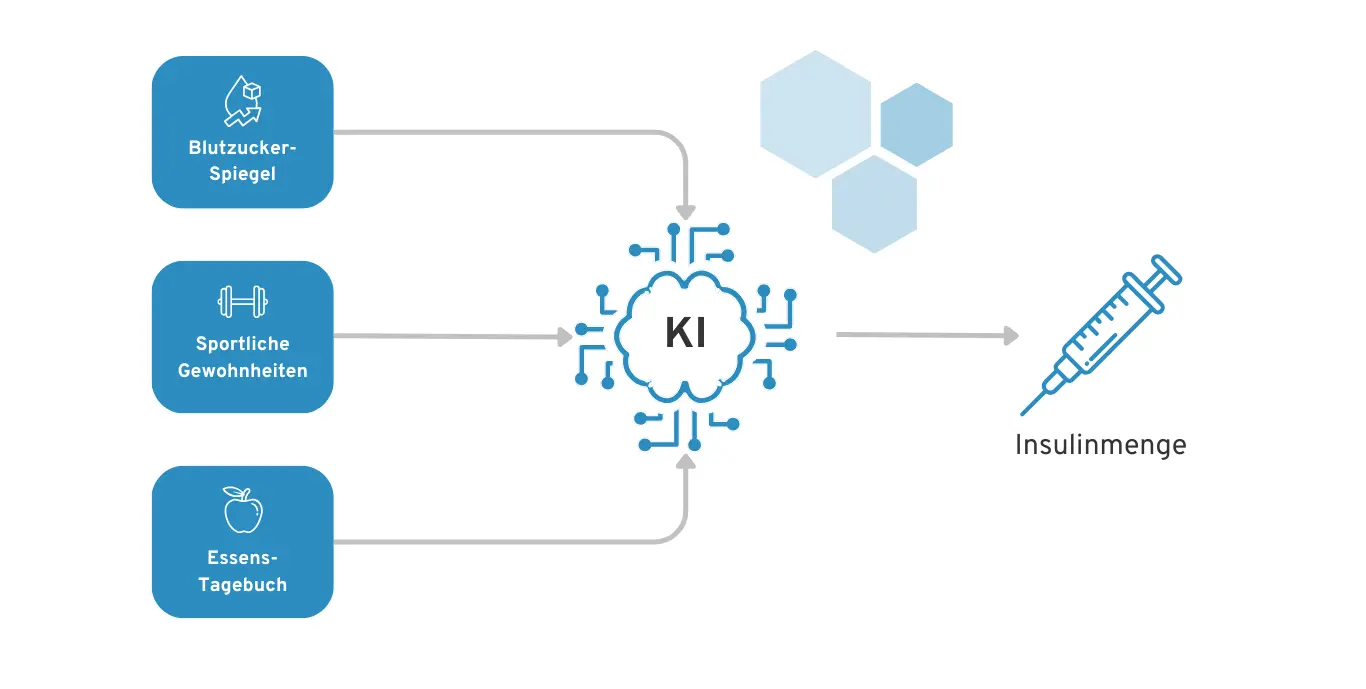

Wir haben eine Diabetes-App, welche auf Basis der Patienten-Daten eine Empfehlung abgibt, wann und wie viel Insulin sich der Diabetes-Patient injizieren sollte. Hierfür werden Daten z. B. über den Blutzucker-Spiegel, das Essens-Tagebuch und sportliche Aktivitäten berücksichtigt.

Beispiel einer KI für Diabetes-Patienten zur Empfehlung der Insulin-Dosierung

Macht es nun einen Unterschied, ob eine KI diese Empfehlung berechnet oder z.B. ein regelbasierter Entscheidungsbaum?

Die Antwort ist leider „Jein“. In der Theorie ist die gesetzliche Grundlage der Medical Device Regulation (MDR) identisch bei klassischer Software und KI-basierter Software.

In der Praxis erwarten Sie bei KI-basierter Software regulatorische Herausforderungen, die durch die technische Natur von KI entstehen. Die wichtigsten Besonderheiten von KI, die im regulatorischen Sinne eine große Rolle spielen, sind die Folgenden:

1.1 Interpretierbarkeit

Eine KI ist meist eine “Blackbox” für den Menschen. Selbst für den Entwickler der KI kann es schwer nachvollziehbar sein, wie genau die künstliche Intelligenz aus den Eingabedaten bestimmte Ausgaben errechnet hat.

Entscheidungen künstlicher Intelligenz sind für den Menschen oft nicht nachvollziehbar

Entscheidungen künstlicher Intelligenz sind für den Menschen oft nicht nachvollziehbar

Es ist in unserem Diabetes-KI-Szenario z. B. erstmal nicht klar, wie genau die Diabetes-KI die konkrete Insulin-Menge und den optimalen Injektionszeitpunkt berechnet. Somit ist es für den KI-Entwickler auch schwer zu sagen, ob das System wirklich in allen Situationen richtig funktioniert. Das birgt natürlich hohe Risiken für den Diabetes-Patienten, der bei einer Unterdosis oder Überdosis Insulin körperlichen Schaden nehmen und sogar sterben könnte.

Ein einfacher Entscheidungsbaum oder z. B. lineare Regressionsmodelle sind für den Menschen transparent nachvollziehbar. Dementsprechend ist es mit dem nötigen medizinischen Fachwissen deutlich einfacher zu validieren, ob das System richtig funktioniert.

Man könnte sagen, dass der Entwickler von herkömmlicher Software bereits vor der Entwicklung weiß, auf welcher Basis Entscheidungen getroffen werden. Die KI hingegen erarbeitet dieses Entscheidungsmodell erst auf Basis der Daten, mit denen sie gefüttert wird und ist nicht zwangsläufig dazu in der Lage, dem Entwickler, Arzt oder Patienten dieses Modell im Nachhinein zu erklären.

Regulatorische Herausforderung: Bei einer Medizinprodukt-Software nach MDR müssen Sie validieren, dass Ihr System funktioniert und keine inakzeptablen Restrisiken existieren. Das ist regulatorisch gesehen gar nicht so einfach, ohne tiefes Verständnis des Software-Systems. Zur Zulassung Ihres KI-Systems sollten Sie daher Erkenntnisse und Methoden aus den Gebieten der Transparenz, Erklärbarkeit und Interpretierbarkeit von KI-Systemen nutzen.

1.2 Kontinuierliches Lernen

Mit KI und speziell Machine Learning entsteht eine Neuheit, die auch regulatorische Herausforderungen mit sich bringt: Systeme, die selbstständig und kontinuierlich weiter lernen. Manche KI-Systeme werden auch während der Nutzung des Produkts fortlaufend trainiert und ändern somit die eigene Verhaltensweise im Live-Betrieb.

Das fortlaufende Lernen der KI passiert jedoch außerhalb des direkten Einflussbereichs des Entwicklers. Dementsprechend ist es umso schwerer vorherzusehen, ob die KI in Zukunft weiterhin richtig funktioniert.

Beispiel: Microsoft hat im Jahre 2016 einen Twitter-Bot veröffentlicht, der automatisiert Tweets generieren konnte. Dieser hat aktiv auf Basis neuer Daten weitergelernt. Durch die absichtliche Manipulation der Community hat der Twitter-Bot aber leider irgendwann viele rassistische Aussagen gemacht. Ein gutes Beispiel dafür, dass selbstlernende Systeme schwerer kontrollierbar sind.

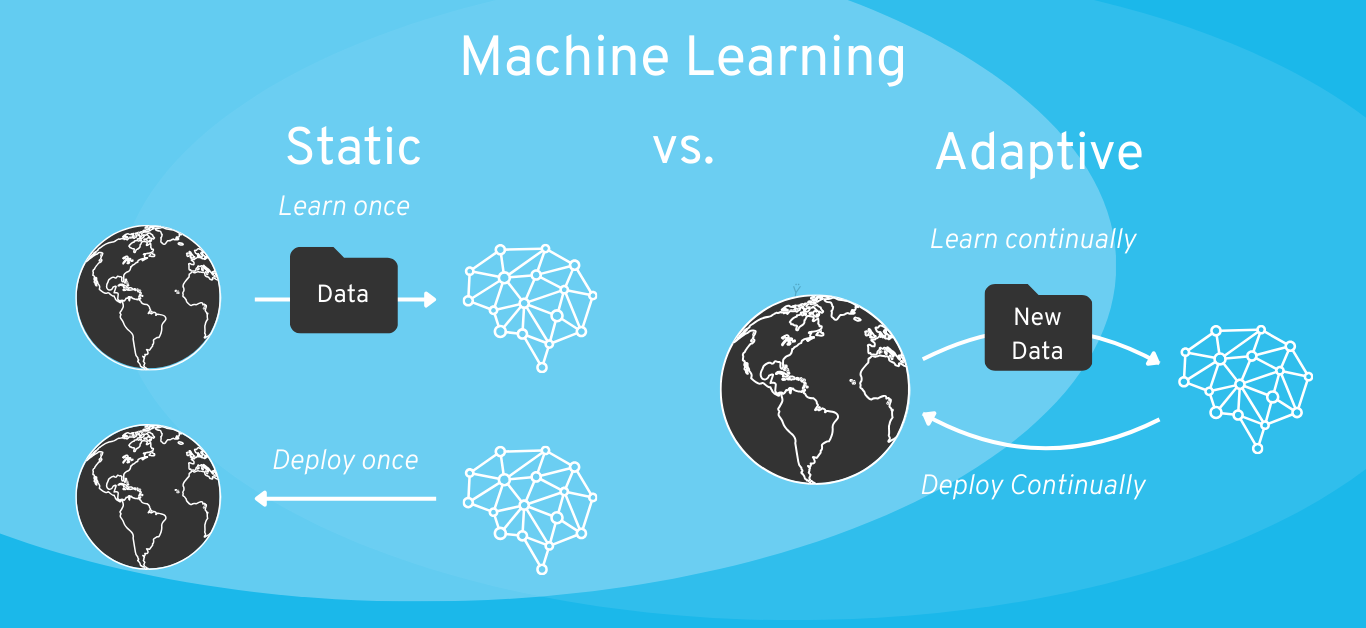

Zum Vergleich, es gibt natürlich auch die Möglichkeit, KI-Systeme nur initial während der Entwicklung mit Daten zu trainieren und nach Integration in das Produkt „einzufrieren“ (auch „statische“ KI genannt). Wie wir weiter unten im Artikel erläutern, sollte dies die präferierte Variante für die meisten Software-Medizinprodukte im Sinne der regulatorischen Zulassung sein.

Regulatorische Herausforderung: Selbst-lernende KI-Systeme ändern noch nach der initialen regulatorischen Zulassung das eigene Verhalten. Diese Verhaltens-Änderung basiert meist auf nicht-validierten Daten, die von Nutzern bereitgestellt werden. Das bringt regulatorische Herausforderungen für die Validierung und das Change-Management (bzw. Änderungsmanagement) im Rahmen des MDR-Medizinprodukts mit sich.

1.3 Abhängigkeit von Daten

Daten sind für ein KI-Medizinprodukt eine zentrale Ressource. Während herkömmliche Software meist auf Basis vordefinierter Regeln funktioniert, leitet ein Machine Learning Algorithmus diese Regeln von den Daten ab, mit denen er trainiert wird.

Wenn Sie ein neuartiges KI-Modell entwickeln wollen, benötigen Sie also zuallererst Daten. Wenn Sie keinen Zugriff auf verlässliche medizinische Daten haben, müssen Sie diese ggf. innerhalb einer klinischen Studie mühsam selbst generieren.

Für vortrainierte Modelle (wie z. B. GPT-4 von ChatGPT) benötigen Sie zwar keine Trainingsdaten. Diese sind aktuell aber leider aufgrund von sog. „Halluzinationen“ selten verlässlich genug für einen medizinischen Anwendungsfall.

Regulatorische Herausforderung: Zur Zulassung eines verlässlichen KI-Modells benötigen Sie Zugriff auf valide, medizinische Daten. Diese Daten zu erhalten, kann kosten- und zeitintensiv sein.

Im nächsten Kapitel gehen wir darauf ein, wie Sie diese Besonderheiten von Artificial Intelligence (AI) bei der Zulassung Ihres Medizinprodukts nach MDR berücksichtigen sollten.

Anmerkung: Der Einfachheit halber werden in diesem Artikel KI allgemein behandeln. Insgesamt schließt dies aber verschiedene Unterkategorien, wie Generative AI, Large Language Models (LLM) und Machine Learning (ML) mit ein. Diese Begriffe werden an einigen Stellen auch beispielhaft verwendet.

2. Zulassung nach MDR: Medizinprodukte mit künstlicher Intelligenz

Es gibt aktuell (noch) keine gesonderten Anforderungen an Software-Medizinprodukte mit KI-Komponenten (Stand: Januar 2025). In der MDR suchen Sie vergebens nach Begriffen wie KI, AI oder Machine Learning.

Regulatorisch gesehen, sind die wichtigsten Normen für Sie bei Software-basierten Medizinprodukten also weiterhin u.a.:

- ISO 13485: Qualitätsmanagementsystem (zum ISO 13485-Guide)

- IEC 62304: Software-Lebenszyklus-Prozesse (zum IEC 62304-Guide)

- IEC 82304: Anforderungen an Gesundheitssoftware

- IEC 62366-1: Gebrauchstauglichkeit

- ISO 14971: Risikomanagement

Mehr Informationen zur Entwicklung von Software-Medizinprodukten (mit oder ohne künstliche Intelligenz) finden Sie hier.

Aktuell gibt es noch keine etablierte (geschweige denn harmonisierte) Norm speziell für die Entwicklung von KI-basierten Medizinprodukten. Künstliche Intelligenz wird im Sinne der MDR und der oben genannten Normen derzeit genauso geregelt wie klassische Software-Produkte.

Ganz so einfach ist es jedoch nicht:

Sie halten sich an dieselben Normen und Gesetze wie bei klassischer Medizinprodukt-Software. Sie müssen dadurch aber natürlich auch wie bei jedem anderen Medizinprodukt u. a. die folgenden Anforderungen abdecken:

- Sie müssen die Sicherheit des Medizinprodukts im Griff haben: Wie hoch ist das Risiko, dass jemand durch Nutzung Ihres Produkts zu Schaden kommt? Wie können Sie dieses Risiko minimieren? Ist das Restrisiko akzeptabel? Etc.

- Sie müssen die Leistungsfähigkeit Ihres Medizinprodukts sicherstellen und nachweisen können: Kann Ihr Produkt die bezweckte Leistung auch wirklich liefern? Können mit Ihrer Software z.B. wirklich Krankheiten diagnostiziert werden oder basiert Ihre Aussage nur auf Bauchgefühl? Mit welcher Genauigkeit und Fehlerrate kann eine Krankheit diagnostiziert werden? Etc.

Bei künstlicher Intelligenz sind die oben genannten Fragen zur Sicherheit und Leistungsfähigkeit meist deutlich schwerer zu beantworten als bei Software mit transparenten, regelbasierten Algorithmen. Das liegt vorwiegend an den im vorangegangenen Kapitel genannten Besonderheiten von künstlicher Intelligenz. KI ist initial erstmal eine „Blackbox“, und die Sicherheit und Leistungsfähigkeit dieser sind scheinbar schwer bewertbar.

Woher wissen Sie, dass Ihre künstliche Intelligenz in jedem Anwendungskontext richtig funktioniert?

Beispiel: Sie entwickeln eine App, welche Hautkrebs mit Hilfe der Kamera Ihres Smartphones diagnostizieren soll. Angenommen, die Trainingsdaten für Ihre KI sind aus Deutschland und beinhalten somit ggf. mehr Bilder von Personen mit helleren Hauttönen als von Personen mit dunkleren Hauttönen. Können Sie sicherstellen, dass die Vorhersage Ihrer KI für Personen mit dunkleren Hauttönen einwandfrei funktioniert? Außerdem: Wie geht Ihr Algorithmus mit einem Bild um, bei welchen zusätzlich eine Narbe oder ein Feuermal zu sehen ist? Sind Sie sich wirklich sicher, dass solche Fälle ausreichend in den Trainingsdaten der KI repräsentiert sind?

Die Herausforderung liegt hier weniger darin, eine spezielle KI-Norm umzusetzen, sondern im Grunde darin:

„Kennen Sie sich gut genug mit der Entwicklung künstlicher Intelligenz aus, um nachweislich eine sicheres und leistungsfähiges KI-Modell zu entwickeln?“

Und auch wenn Sie die Expertise haben, ist es insbesondere in Deutschland nicht einfach an medizinische Daten für das Training Ihrer KI zu kommen. Die zweite große relevante Frage ist also:

„Haben Sie genug hochqualitative Trainingsdaten für Ihren Anwendungsfall?“

2.1 Anforderungen an die Entwicklung von KI-Medizinprodukten

Wie oben schon beschrieben, gibt es zum aktuellen Zeitpunkt noch keine harmonisierte Norm für MDR-Medizinprodukte, welche konkrete Anforderungen an die Entwicklung von KI-Medizinprodukt definiert. Es gibt jedoch auch jetzt schon Normen und Guidelines, an denen Sie sich orientieren können, um die wichtigen Aspekte abzudecken.

Zur Veranschaulichung der technischen Komplexität haben wir eine beispielhafte Frageliste zusammengestellt. Um sicherzustellen, dass Ihre KI am Ende nicht die falschen Krankheits-Diagnosen stellt oder gefährliche Therapie-Anweisungen gibt, sollten Sie sich z. B. mit folgenden Aspekten befassen:

| Frage | Beispiel für mögliches Problem |

| Woher stammen die Trainingsdaten für Ihre KI? | Ihre Trainingsdaten sind aus einer Quelle, für die Sie die Validität der Daten nicht überprüfen können. Die Daten repräsentieren die reale Welt nicht ausreichend und Ihre KI ist fehlerhaft in der Anwendung. |

| Repräsentieren die Trainingsdaten Ihren Anwendungsfall und die Ziel-Patientengruppe ausreichend? | Ihre Trainingsdaten decken nur einen von vielen Anwendungskontexten ab. Die KI funktioniert nur einem Kontext und schlägt in anderen Situationen fehl. |

| Wie definieren Sie die „Wahrheit“ („Ground Truth“) im Rahmen Ihres Machine Learning-Modells? Woher stammen die Labelling-Daten für Ihr Modell und können Sie der Wahrheit dieser Labels vertrauen? | Die Labels für Ihre Trainingsdaten wurden von einer einzigen Person nach subjektiver Einschätzung vergeben. Andere Personen hätten für die gleichen Daten unterschiedliche Labels vergeben. Die Labels repräsentieren keine fundamentale Wahrheit. |

| Wurde Ihr Modell mit Daten validiert, die nicht zuvor für das Training und Testing verwendet wurden? | Ihr KI wurde mit denselben Daten validiert, die auch im Training und Testing verwendet wurden. Die Validierung ist demnach erfolgreich für die Trainingsdaten, die KI ist aber fehlerhaft für komplett neue Daten im Live-Betrieb des Produkts (auch „Overfitting“ genannt). |

| Haben Sie die Ziel-Patientengruppe und Ziel-Nutzungsumgebung ausreichend charakterisiert und eingegrenzt?

|

Ihre Trainingsdaten decken nur einen von vielen Anwendungsbereiche Ihres KI-Produkts ab. Die KI funktioniert also nur in den Szenarien, für die Sie auch trainiert wurde, aber nicht in anderen Szenarien, die jedoch Teil des echten Anwendungsbereichs sind. |

| Wie reagiert Ihr Modell auf Daten, die es während des Trainings nicht gesehen hat, insbesondere auf seltene oder atypische Fälle? | Ihre KI könnte bei seltenen Krankheitsbildern oder atypischen Patientendaten falsche Diagnosen stellen oder ungeeignete Therapien vorschlagen, da sie für solche Fälle nicht angemessen trainiert wurde. |

| Wie robust ist Ihr Modell gegenüber Manipulationen oder externen Angriffen, insbesondere wenn es um die Sicherheit der Patientendaten geht? | Anfälligkeiten für Cyberangriffe könnten nicht nur die Funktionsfähigkeit Ihrer KI beeinträchtigen, sondern auch sensible Patienteninformationen gefährden. |

| Haben Sie Methoden verwendet, die es ermöglichen, die Entscheidungen Ihrer KI zu erklären und nachzuvollziehen? | Ohne Erklärbarkeit könnte es schwierig sein zu verstehen, wie die KI zu einer bestimmten Diagnose oder Therapieempfehlung gekommen ist. Ihr KI-Modell könnte fehlerhaft sein, ohne dass Sie davon wissen. |

| Enthalten Ihre Daten alle notwendigen Merkmale (Features) und können Sie die Auswahl der observierten Merkmale begründen? | Ihre Trainingsdaten enthalten nicht alle relevanten Merkmale, die für eine präzise Diagnose oder Therapieempfehlung notwendig sind. |

| Etc. | Etc. |

Dies sind nur einige Beispiele zur Veranschaulichung der Komplexität und die Liste könnte ohne Probleme noch um viele Punkte erweitert werden. Eine gute Liste relevanter Fragen finden Sie auch im neuen Fragenkatalog für benannte Stellen zum Thema künstliche Intelligenz in Medizinprodukten. Das führt uns zum nächsten Punkt:

2.2 Was erwartet die benannte Stelle in Bezug auf KI-basierte Medizinprodukte?

Ein Blick in den aktuellen Fragenkatalog für benannte Stellen für KI-basierte Medizinprodukte lohnt sich.

Hier finden Sie die aktuellen Versionen zum Download: Fragebogen der benannten Stellen

(Tipp: Holen Sie sich einen Kaffee und warten einige Minuten, bis der Download startet. Scheinbar sind die Server der IG-NB durchgehend überlastet.)

Fragebogen der benannten Stellen zu künstlicher Intelligenz

Fragebogen der benannten Stellen zu künstlicher Intelligenz

Sie sollten damit rechnen, im Audit Ihres Medizinprodukts mit derartigen Fragen der benannten Stelle konfrontiert zu werden. Sie benötigen hier jeweils eine schlüssige Antwort, die sich auch in der technischen Dokumentation Ihres Medizinprodukts wiederfindet.

Falls Sie ein KI-Software-Produkt entwickeln, das unter die Risikoklasse I nach MDR fällt, erwartet Sie zumindest unter MDR kein Audit der benannten Stelle (eine benannte Stelle könnte aber für das Konformitätsbewertungsverfahren für den AI-Act für KI-Produkte notwendig sein. Lesen Sie mehr darüber in diesem Artikel.). Sie werden jedoch zu unangekündigten Zeitpunkten von Ihrer Aufsichtsbehörde geprüft. Auch hier lohnt sich ein Blick in den Fragenkatalog.

Benötigen Sie Unterstützung bei der Entwicklung eines medizinischen KI-Systems?

Wir entwickeln medizinische KI-Systeme für Unternehmen im Gesundheitswesen auf Auftragsbasis.

Unsere KI-Services:

– Technischer Review von medizinischen KI-Systemen

– Entwicklung von neuen Machine Learning-Modellen im Gesundheitsbereich

– Individuelle Beratung bezüglich regulatorischer Compliance für Ihr geplantes KI-basiertes Produkt

2.3 Relevante Normen und Leitfäden für künstliche Intelligenz in Medizinprodukten

Wie oben schon erwähnt, erwarten Sie im Rahmen der MDR erstmal keine konkreten neuen gesetzlichen Verpflichtungen für KI-Produkte.

Provokativ gesagt: Wenn Sie diese klassischen Normen für die Entwicklung von medizinischer Software akribisch einhalten, brauchen Sie keine AI-Norm.

Die praktischen Implikationen der MDR für die Umsetzung der KI ergeben sich indirekt u. a. aus:

- … den Kontrollmaßnahmen für Risiken der KI in Bezug auf die menschliche Gesundheit (ISO 14971).

- … der verpflichtenden Verifizierung und Validierung des KI-Systems (ISO 13485, IEC 62304).

In der Praxis ist es aber aus den folgenden Gründen ratsam, sich mit bestimmten KI-spezifischen Normen und Leitlinien zu beschäftigen:

- Hilfestellung für die Entwicklung: Die Entwicklung von verlässlichen KI-Algorithmen ist komplex. Wenn Sie in diesem Bereich nicht absoluter Experte sind, hilft ein Leitfaden, um alle technischen Risiken von KI zu identifizieren und effektiv abzuwenden.

- Interpretationsspielraum der MDR und Medizinprodukt-Normen: Verschiedene Prüfstellen haben andere Interpretationen der MDR-Anforderungen und Normen. Ein Blick in den Fragebogen der benannten Stellen hilft Ihnen dabei, die Erwartungshaltung Ihres zukünftigen Auditors besser zu verstehen.

- Argumentationsbasis im Audit: Ihr Auditor wird wissen wollen, wie Sie sicherstellen, dass Ihre KI verlässlich funktioniert. Wenn Sie darauf antworten „Ich bin KI-Experte und weiß sowas einfach“ ist das für Auditoren eine deutlich weniger zufriedenstellende Antwort als „Wir haben uns bei der Entwicklung und Validierung an die folgenden Normen und Leitlinien gehalten.“. Die öffentliche Akzeptanz einer Norm oder Leitlinie schafft Vertrauen in der Kommunikation mit dem Auditor.

Einige KI-spezifische Leitlinien und Normen, die für Sie in diesem Rahmen relevant sein könnten, sind die z.B. Folgenden:

- Leitfäden der FDA zum Einsatz von Machine Learning in Software as a Medical (SaMD):

- Fragebogen der benannten Stelle

- Leitfaden zur KI bei Medizinprodukten von Christian Johner, Christoph Molnar et al.

- BS/AAMI 34971:2023, Application of ISO 14971 to machine learning in artificial intelligence

- ISO/IEC TR 24028:2020, Edition 1.0 – Information technology – Artificial intelligence – Overview of trustworthiness in artificial intelligence

- ISO/IEC TS 4213:2022, Information technology – Artificial intelligence – Assessment of machine learning classification performance

- ISO/IEC FDIS 23894 Information technology — Artificial intelligence — Guidance on risk management

- ISO/IEC 5338 Information technology — Artificial intelligence — AI system life cycle processes

- ISO/IEC FDIS 5339 Information Technology – Artificial Intelligence – Guidance for AI applications

- ISO/IEC DIS 5259-2 – Artificial intelligence — Data quality for analytics and machine learning (ML) — Part 2: Data quality measures

- ISO/IEC DIS 5259-3 – Artificial intelligence — Data quality for analytics and machine learning (ML) — Part 3: Data quality management requirements and guidelines

- ISO/IEC 5259-4 – Artificial intelligence — Data quality for analytics and machine learning (ML) — Part 4: Data quality process framework

Wir hoffen, dass sich in naher Zukunft eine Norm (oder mehrere) für die Entwicklung von KI-basierten Medizinprodukten etabliert und harmonisiert wird. Ein etablierter Standard hilft sowohl den Firmen bei der Entwicklung als auch den benannten Stellen bei der Auditierung. Wann dies passiert, ist aber bisher nicht absehbar.

2.4 Welche Machine Learning-Modelle sind als Medizinprodukt zertifizierbar?

Bei der Beantwortung dieser Frage scheinen sich selbst die benannten Stellen schwer zu tun. In einer früheren Version des Fragebogens für benannte Stellen (Version 4, vom 09.06.2022) stand noch explizit:

- “Static locked AI” ist zertifizierbar (Produkte mit abgeschlossenem Lernprozess und nachvollziehbaren Entscheidungen)

- “Static black box AI” ist im Einzelfall zertifizierbar (Produkte mit abgeschlossenem Lernprozess und nicht bzw. nur teilweise nachvollziehbaren Entscheidungen)

- “Continuous learning AI” ist nicht zertifizierbar (Produkte, deren Lernprozess im Feld weitergeht)

Im neuen Fragebogen (Version 1, vom 14.11.2024), in dessen Erstellung nun auch das Team NB – The European Association of Medical devices Notified Bodies eingebunden ist, scheint diese klare Vorgabe aber abgeschwächt worden zu sein. Gerade für letztere gibt es in der Theorie nun doch Möglichkeiten einer Zertifizierung, sofern geeignete Maßnahmen vom Hersteller etabliert wurden.

„Die Praxis hat gezeigt, dass es für die Hersteller schwierig ist, die Konformität von KI-Geräten, die die zugrunde liegenden Modelle durch selbstlernende Mechanismen im Feld aktualisieren, ausreichend nachzuweisen. Derzeit betrachten die benannten Stellen Medizinprodukte, die auf solchen Modellen basieren, nicht als „zertifizierbar“, es sei denn, der Hersteller ergreift Maßnahmen zur Gewährleistung des sicheren Betriebs des Produkts im Rahmen der in der technischen Dokumentation beschriebenen Validierung.“

(Übersetzt aus dem Englischen)

Was genau diese “Maßnahmen zur Gewährleistung des sicheren Betriebs des Produkts” in der Praxis aber sind, bleibt offen. Auch wenn die ursprüngliche Aussage, dass eine Zertifizierung von „Continuous learning AI“ unmöglich ist, entfernt wurde, ist immer noch nicht klar definiert, in welchen Fällen eine Ausnahme gemacht werden kann. In der Praxis hängt dies auch stark mit der Risikoklasse des Produkts zusammen. Je nach Ausmaß des möglichen Schadens bei Fehlverhalten der KI, können Restrisiken durch selbst-lernende Systeme akzeptiert werden oder nicht.

Machine Learning-Modell: Statisch vs. Adaptiv (bzw. „selbstlernend“)

Wenn Sie die Entwicklung eines Continuous Learning Systems planen, sollten Sie auf jeden Fall definieren, in welchem Ausmaß der Algorithmus im Feld weiterlernen darf.

Beispiel: Hier muss man dann auch im Rahmen des Risikomanagements analysieren, welche Art von Risikokontrollmaßnahmen man einführen könnte. Bei einer Insulin-Pumpe könnte man z.B. sagen, dass Minimum und Maximum der Insulin-Dosis fest definiert werden und nur die Optimierung dazwischen auf KI basiert.

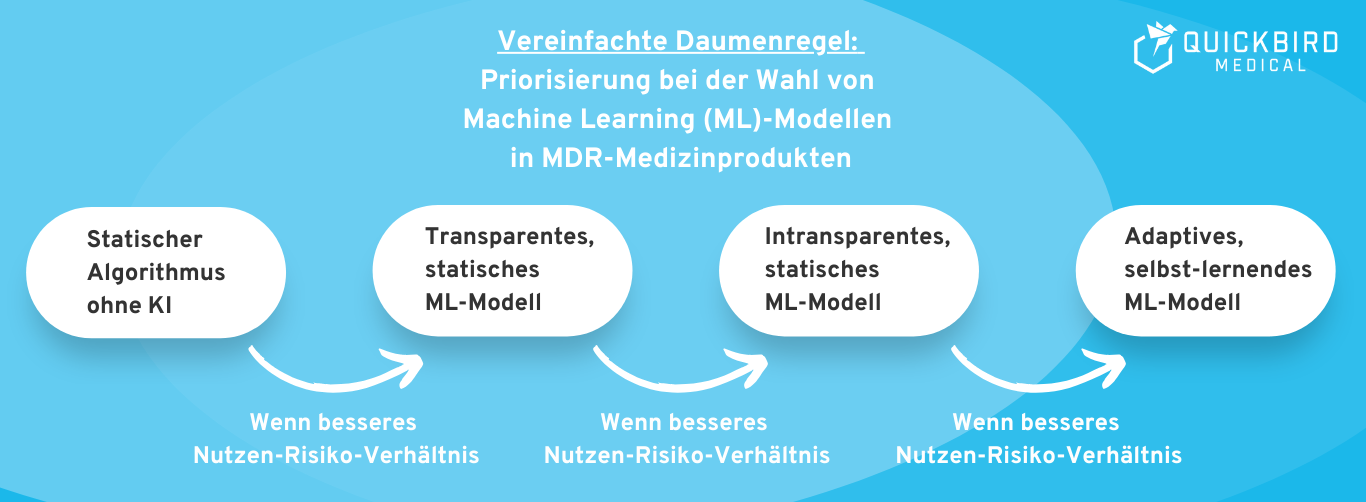

Daumenregel: Grundsätzlich gilt die Daumenregel, ein einfacheres (interpretierbareres) ML-Modell einer “Black Box” vorzuziehen, und statische KI einem selbstlernenden KI-System vorzuziehen. Sprechen Sie Ihren Plan ggf. mit Ihrer benannten Stelle ab (für Risikoklasse IIa oder höher). Der Interpretationsspielraum der Gesetzgebung ist groß und für unterschiedliche Auditoren müssen Sie daher auch mit einer jeweils unterschiedlichen Erwartungshaltung rechnen.

Bild: Stark vereinfachte Daumenregel: Welche Art von KI sollten Sie wählen?

2.5 Können Sie LLMs wie ChatGPT in Ihrem Medizinprodukt nach MDR nutzen?

Generative AI und speziell Large Language Models (LLMs) haben großes Potenzial in der Medizin. Zu den aktuell bekanntesten LLMs gehören z. B.:

- GPT-5.2 von OpenAI (wird in ChatGPT genutzt)

- Llama von Meta

- Claude von Anthropic

- Speziell im medizinischen Bereich: z. B. Med-PaLM von Google

Der große Vorteil von diesen LLMs:

- Es handelt sich um vortrainierte Modelle. Sie müssen das KI-Modell nicht selbst trainieren und benötigen somit auch keine Trainingsdaten.

- Die Fähigkeiten dieser vortrainierten Modelle sind vielfältig. Durch den Einsatz von LLMs werden viele Innovationen in der Medizin möglich, die bisher nicht vorstellbar waren.

Können Sie Generative AI und speziell LLMs also regulatorisch gesehen in Ihrem Medizinprodukt nutzen?

Regulatorisch gesehen gibt es hier keinerlei explizite Einschränkungen. Sie können potenziell jedes Machine Learning-Modell verwenden, solange Sie sicherstellen, dass das Produkt sicher ist und seinen medizinischen Zweck erfüllt.

Leider sind LLMs aktuell noch nicht verlässlich genug für viele medizinische Anwendungsfälle (Stichwort: „Halluzinationen“). Dadurch ergibt sich bei vielen Einsatzgebieten ein nicht akzeptables Risiko für Ihr Medizinprodukt nach MDR. Für weniger kritische Einsatzgebiete ist es aber nicht explizit ausgeschlossen, dass Sie ein LLM in Ihr Medizinprodukt zu integrieren. Dies muss jeweils im Einzelfall betrachtet werden.

In Zukunft werden LLMs sicherlich kontinuierlich weiter verbessert, was viele neue Einsatzgebiete in der Medizin ermöglichen wird.

2.6 Kosten und Aufwand für die Zulassung

Faktor 1: Risiken Ihres Medizinprodukts

Wie präzise Sie bei der Entwicklung und Validierung Ihres KI-Modells arbeiten müssen, hängt stark von der Höhe der Risiken Ihrer Medizinprodukt-Software ab. Je höher das Risiko Ihres Produkts, desto aufwendiger und kostenintensiver wird die Zulassung.

💡 Beispiel eines hohen Risikos:

Angenommen, Sie entwickeln einen KI-Algorithmus, welcher die optimale Strahlungsdosis für ein Bestrahlungsgerät berechnen soll. Wenn Ihr KI-System einen Fehler macht, kann der Krebs-Patient im schlimmsten Fall durch eine Strahlungs-Überdosis sterben. Dementsprechend viel Aufwand müssen Sie bei der Entwicklung und Validierung Ihrer Medizinprodukt-Software investieren, um die Wahrscheinlichkeit eines Fehlverhaltens nahezu gegen Null laufen lassen.

💡 Beispiel eines niedrigen Risikos:

Angenommen, Sie entwickeln eine digitale Gesundheitsanwendung für die Behandlung von Adipositas bzw. Übergewicht. Ihr KI-System soll nun je nach Tageszeitpunkt und Stimmung des Nutzers, die optimale Fitnessübung vorschlagen. Wenn Ihr Algorithmus ab und zu mal eine nicht ganz optimale Empfehlung abgibt, kommt nicht direkt jemand zu Schaden. Entsprechend haben Sie bei der Entwicklung des KI-Systems die Möglichkeit eine gewissen Fehlerquote als Restrisiko zu akzeptieren. Der Aufwand für die Entwicklung und Validierung des Systems ist überschaubar.

Daumenregel:

Sie benötigen deutlich mehr Daten und müssen mehr Zeit in die Entwicklung Ihres AI-Modells stecken, wenn Ihr Produkt in einer höheren Risikoklasse nach MDR und einer höheren Sicherheitsklasse nach IEC 62304 angesiedelt ist.

Faktor 2: Nutzen Ihres Medizinprodukts

Nach MDR muss ein Medizinprodukt die Risiken immer dem Nutzen gegenüberstellen. Ein neuartiges Medizinprodukt mit hohem Nutzen kann also unter Umständen auch größere Risiken akzeptieren.

Ein KI-Produkt mit seltenen Fehlern, welches durch den Einsatz deutlich mehr Menschenleben rettet als durch Nicht-Anwendung des Medizinprodukts, kann potenziell trotzdem zugelassen werden.

Wenn Ihr Produkt jedoch mit klassischen, regelbasierten Algorithmen genauso zuverlässig funktionieren würde, sollten Sie Abstand von KI nehmen. Sie haben die Pflicht, alle Risiken Ihres Medizinprodukts so weit wie möglich zu reduzieren. Da durch KI viele neue Risiken entstehen, ist ein einfacher, transparenter Algorithmus ist Zweifelsfall vorzuziehen.

3. Weitere regulatorische Anforderungen für KI

Neben der Medical Device Regulation (MDR), betreffen Sie ggf. noch andere gesetzliche Vorgaben:

- Datenschutz-Grundverordnung (DSGVO): Die DSGVO geht zwar nicht speziell auf KI in ihrem Wortlaut ein, hat aber durchaus Implikationen für diese. Wichtigste Implikationen der DSGVO entstehen z. B. durch die Anforderung von „technischen und organisatorischen Maßnahmen“ (TOM) zum Schutz von personenbezogenen Daten. In Bezug auf Cyber Security ergeben sich z. B. spezielle Herausforderungen für KI-Systeme.

- Artificial Intelligence Act (AI Act) der Europäischen Union: Der AI Act reguliert den Einsatz von KI innerhalb der Europäischen Union. Da der EU-AI Act keine Verordnung speziell für Medizinprodukte ist und eine Erklärung dessen den Rahmen des Artikels sprengen würde, gehen wir in diesem Artikel nicht näher auf diese Neuregelung ein. Sie finden hier einen detaillierten Leitfaden zum AI Act speziell für Medizinprodukt-Hersteller.

Wir beschränken uns in diesem Leitfaden auf die Gesetzgebungen, die speziell für KI größere Auswirkungen haben können. Natürlich gibt es eine Vielzahl weiterer Gesetze, die für jedes Software-Produkt gelten.

4. Fazit

Künstliche Intelligenz ist natürlich auch für regulierte Medizinprodukte nach MDR zulassungsfähig. Wie viel Aufwand und Kosten damit einhergehen, hängt vom Risiko und Nutzen Ihrer Medizinprodukt-Software ab.

Grundsätzlich sollten Sie sich überlegen, ob der Einsatz von künstlicher Intelligenz Ihr Produkt in Bezug auf die Zweckbestimmung signifikant besser macht. Wenn Sie mit einem transparenten, regelbasierten Algorithmus ähnliche Ergebnisse erzielen können, sollten Sie ggf. auf KI verzichten. Der Aufwand ist es für Ihr Unternehmen womöglich nicht wert und die benannte Stelle wird die Entscheidung für ein KI-basiertes System hier ggf. auch anzweifeln.

Wenn Ihr KI-Algorithmus hingegen Mehrwerte schafft, die mit klassischen Algorithmen nicht erreichbar sind, dann möchten wir Ihnen an dieser Stelle Mut zusprechen.

In den USA sind Stand Januar 2025 bereits über 1.000 medizinische KI-Systeme zugelassen worden und auch in Europa erhalten regelmäßig neue Firmen die Zulassung für ihr KI-Systems nach MDR. KI in der Radiologie ist zum Beispiel schon längst keine Neuheit mehr und erreicht in diesem Bereich Dinge, die mit regelbasierten Algorithmen schlichtweg nicht möglich wären.

Benötigen Sie Unterstützung bei der Entwicklung eines medizinischen KI-Systems?

Wir entwickeln medizinische KI-Systeme für Unternehmen im Gesundheitswesen auf Auftragsbasis.

Unsere KI-Services:

– Technischer Review von medizinischen KI-Systemen

– Entwicklung von neuen Machine Learning-Modellen im Gesundheitsbereich

– Individuelle Beratung bezüglich regulatorischer Compliance für Ihr geplantes KI-basiertes Produkt

Ob als Funktion innerhalb von digitale Gesundheitsanwendungen (DiGA) oder als Decision Support Systeme für Ärzte, wir entwickeln passende Machine Learning-Modelle für Ihren Anwendungsfall. Falls Sie ein KI-basiertes Medizinprodukt planen, kontaktieren Sie uns gern. Wir beraten Sie individuell zu Ihrem geplanten Produkt und setzen bei Bedarf das gesamte Software-System für Sie um.